Egy kutatás szerint a mesterséges intelligencia érveinek hatására sokan kételkedni kezdtek a korábban megkérdőjelezhetetlennek hitt elméleteikben. Persze nem mindenki hajlandó leülni beszélni egy AI-val.

Ma már szinte mindenki meg tud nevezni legalább egy laposföldes szomszédot, chemtrailes barátot, oltásellenes rokont vagy holdutazást tagadó ismerőst, sőt, az óvatlanabbak néha leállnak vitatkozni a gyíkemberes kollégával is. A merészebb összeesküvés-elméletek nagy horderejű eseményekről szólnak: CIA-s konspirációnak tartják 9/11-et, esetleg fikciónak nevezik több száz év eseményeit a történelemkönyvekből.

Mivel a hazugságot könnyebb elfogadni, mint a tények megismerésével fáradni, az összeesküvés-elméletek elképesztően sikeresek - és ebben elévülhetetlen érdemeket szerzett a közösségi média.

Ami szerencsétlen fordulat, hiszen az internet adta lehetőségek nemcsak a légből kapott elméletek terjesztését könnyítik meg a konteóhívők számára, hanem annak ellenkezőjét is: alkalmat adnak rá, hogy kinézzenek az alufóliasapka alól, és észrevegyenek tudományos magyarázatokat, logikus érveket.

Mivel ettől még igaz marad, hogy az összeesküvés-elméleteket gyakran kényelmesebb befogadni, mint az igazságot megérteni, rendkívül hasznosnak bizonyulhat egy új kezdeményezés, ami a mesterséges intelligencia egyszerűen használható eszközeivel magyarázza el a megvezetett embereknek, hogy hazugságokban hisznek.

Amerikai kutatók ugyanis bebizonyították, hogy a mesterséges intelligencia alkalmasabb vitapartner lehet az embernél, ha összeesküvés-elméletekről van szó, hiszen szinte végtelen információ áll rendelkezésére és empatikusabb is, mint a konteósokat gyakran lenéző másik személy.

Az összeesküvés-elméletek kuzinja: a dezinformáció

Az utóbbi években a politikát követő olvasók kimerítő mennyiségben találkoztak hamis hírekkel, amelyek, ha nem is mindig járnak velük kéz a kézben, egy tőről fakadnak az összeesküvés-elméletekkel. Már csak a közönségük miatt is: annak, aki elhiszi, hogy chipet injekcióztak a bőre alá a COVID-oltással, nem kell nekifutásból magyarázni az illuminátusokat vagy a mélyállamot, hiszen szomjazza a hihetetlen és sokkoló állítások izgalmát.

Egyes pszichológiai elméletek szerint az emberek valamilyen belső pszichés szükséglet vagy motiváció kielégítésére fogadják el ezeket az elméleteket, és pont ezért nem győzhetők meg tényekre alapozott cáfolatokkal.

Az, hogy a logikus érvekkel megmagyarázhatatlant sokan elhiszik, jól mutatja, hogy a közösségi média és a politikai megosztottság korában mennyire elmosódtak a határok az igazság és az összeesküvés-elméletek között. Egy új tudományág, a debunkológia (a neve az angol „debunk”, vagyis leleplezni szóból ered) éppen ennek köszönheti a létjogosultságát: azt kutatja, hogy hogyan lehet egy rögzült hiedelmet elmozdítani az emberek fejében.

A propaganda meggyőző hatásait és azok ellenszereit vizsgáló Kurt Braddock, a washingtoni American University kutatója a The Economistnak azt mondta, az érvelés és a vita, amivel a legtöbben próbálkoznak egy összeesküvés-hívővel szemben, ritkán válik be. Mi több, gyakran pont az ellenkezőjét érik el: csak még jobban megerősítik benne a hamis nézeteket. A legújabb debunkológiai kutatások ugyanakkor arra engednek következtetni, hogy a meggyőzés eredményesebb lehet, ha a beszélgetőtárs nem szomszéd, barát, rokon, ismerős vagy kolléga, hanem a generatív mesterséges intelligencia.

Az AI meggyőzőbben cáfol, mint az ember

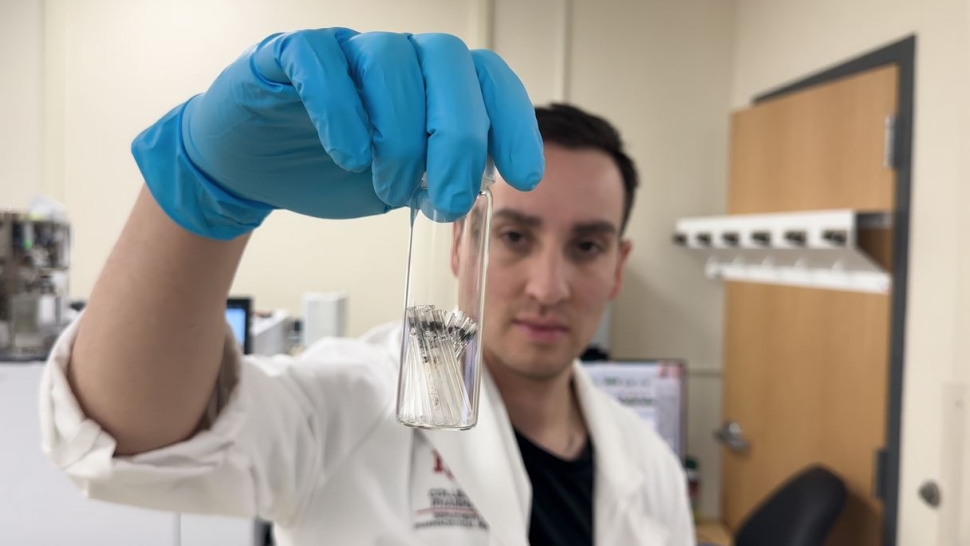

A Massachusettsi Műszaki Egyetem (MIT) tudósai Thomas Costello adjunktus vezetésével vittek végig egy alapos kutatást arról, hogy mi történik, ha a ChatGPT összeesküvés-elméletekben hívő embereket próbál lebeszélni a nézeteikről. A kutatásban 2190, önmagát összeesküvéselmélet-hívőként azonosító amerikai vett részt: egytől egyig leültek a chatbot korábbi, GPT-4 modelljével egy háromkörös beszélgetésre a számukra fontos és végletekig meggyőző témákról.

A résztvevők elmondták, milyen konspirációban hisznek, az AI pedig bizonyítékokra alapozott állításokat hozott fel az elmélettel szemben. A chatbot személyre szabott és részletes ellenérvei, ha korlátozott időtartamra is, de képesek voltak csökkenteni az összeesküvésbe vetett hitet, vagyis sikerült megkérdőjelezni azt a kutatói álláspontot, miszerint a hiedelmeket nem lehet megváltoztatni a hívők fejében.

És az MIT ezzel tudományos drágakőre lelt: bebizonyította, hogy az AI alkalmazható a társadalmi konfliktusok mérséklésére.

Persze csak akkor, ha a jövőben elég nagy számban sikerül elé ültetni összeesküvés-hívőket, és úgy fejlesztik tovább ezirányú képességeit, hogy a beszélgetés hatása tartós maradjon. Costelloék kutatása pedig biztató rajt, hiszen bebizonyította, hogy a meggyőző bizonyítékok megfelelő tálalásával ki lehet zökkenteni az embereket a konspirációs őrületből.

A Science-ben közölt tanulmány szerint a tudósok azt feltételezték, hogy a tényalapú, helyesbítő információkra épülő meggyőzés azért maradhat hatástalan, mert nem elég mély vagy nem elég személyre szabott. A nagy nyelvi modellek (LLM-ek) viszont éppen abban jók, hogy hatalmas mennyiségű információhoz férnek hozzá, és képesek egyedi érvek megfogalmazására, így közvetlenül tudják cáfolni azokat a „bizonyítékokat”, amelyekre a hívők az összeesküvés-elméletek igazolásaként hivatkoznak.

A tudósok két kísérlet után arra jutottak, hogy a LLM-es közvetítéssel zajló beavatkozás átlagosan 20 százalékkal csökkentette a résztvevők összeesküvés-elméletekbe vetett hitét, és ez a hatás legalább két hónapon át fennállt.

A csökkenés különféle összeesküvés-elméletek esetében is megfigyelhető volt, a klasszikusoktól (John F. Kennedy meggyilkolása, a földönkívüliek vagy az illuminátusok) az aktuális témákig (COVID-19, 2020-as amerikai elnökválasztás). A hatás még azoknál is jelentkezett, akiknél a hit mélyen beágyazódott és az identitásuk részét képezte. És történt mindez úgy, hogy egy profi tényellenőrző szerint az AI által használt 128 állítás 99,2 százaléka igaz volt, vagyis csak a válaszai 0,8 százaléka tartalmazott téves információt. Az egy adott elméletre adott cáfolata mindemellett csökkentette a más összeesküvésekbe vetett hitet is, ami arra utal, hogy a résztvevőkben általánosan mérséklődött a konspirációs világszemlélet, miközben nőtt a hajlandóságuk más hívők meggyőzésére.

Thomas Costello a CNN Terms of Service with Clare Duffy című podcastjének vendégeként megerősítette, hogy a kísérletben alkalmazott LLM-et nem képezték ki a kísérletben előkerült konspirációkból, hanem hagyták, hogy ugyanúgy az interneten található információkra támaszkodjon, mint bármely más csevegés esetében. Ebből következik, hogy ugyanolyan formában és arányban találkozott összeesküvés-elméletekkel, mint az internetező hívők, de ez mégsem rontott az ítélőképességén: nem hagyta helyben a hívők állításait, ha azokra talált meggyőző ellenérvet. Érdekes kivétel volt a földönkívüli élet létezésével kapcsolatos téma, amelyben nincs tudományos konszenzus, ahogy megdönthetetlen bizonyíték sem létezik, így az AI nem feltétlenül akarta cáfolni az alanyok állításait, inkább beszélgetésbe elegyedett velük a témáról.

Az adjunktus szerint a ChatGPT úgy volt képes rávezetni az igazságra az összeesküvés-hívőket, hogy fenntartotta a kíváncsiságukat, és úgy alakította a beszélgetést, hogy végig megmaradjon a pozitív hozzáállásuk.

A modell a rengeteg rendelkezésére álló információval - kvázi azzal, hogy mindenre volt válasza -, illetve a megértő csevegési stílussal elérte, hogy a résztvevők negyede kifejezetten szkeptikussá vált a korábban hitt elmélettel szemben.

„Az AI tulajdonképpen egy nagyon hatékony keresőeszköz. És annyi információ van odakint az interneten, amelyek közül sok még akkor is igaz, legalább egy kis részben, ha összeesküvés-elméletekhez kötődik. A repülőgép-üzemanyag például valóban nem ég elég forrón, hogy megolvassza a vasbeton szerkezetet” - utalt a tudós az egyik népszerű 9/11-es elméletre, amely szerint nem a repülők becsapódása miatt omlott le a Világkereskedelmi Központ. Úgy véli, hogy ilyen részigazságokkal operálva („tényleg nem olvad a beton”) ki lehet alakítani azt a kontextust, amelyre a hívőknek szüksége van ahhoz, hogy meggyőzhetőek legyenek, és az AI ebben remekül teljesített.

A kutatás következtetése szerint sokan, akik erősen hisznek a tényekkel megalapozott cáfolatoknak látszólag ellenálló összeesküvés-elméletekben, megváltoztathatják a nézeteiket, ha elég meggyőző bizonyítékot kapnak.

Elméleti szempontból ez meglepően derűlátó képet fest az emberi gondolkodásról. Arra utal, hogy az összeesküvéses „nyúlüregből” tényleg van kiút, a pszichológiai szükségletek és motivációk pedig önmagukban nem vakítják el a híveket a bizonyítékokkal szemben – csak éppen a megfelelő bizonyítékokra van szükség. Gyakorlati szempontból az eredmények jól demonstrálják a generatív AI meggyőző erejét, és rámutatnak: a felelős használat komoly társadalmi előnyöket jelenthet, de közben nagyon fontos csökkenteni a visszaélések lehetőségét.

Az igazán hajthatatlan hívők tényleg megbíznak egy robotban?

Bár a fent leírt kutatás pozitív lehetőségekkel kecsegtet, érdemes megjegyezni, hogy nem minden hívő hajlandó leülni és egy géppel vitatkozni, vagyis más stratégiákra szintén szükség van ahhoz, hogy az összeesküvés-elméleteket le lehessen győzni. Ennek egyik módja a megelőzés lehet - emlékeztet a The Economist, arra a 1960-as évek óta létező elméletre hivatkozva, amit nem túl fülbemászó módon attitűdinokulációnak hívnak.

A kifejezést William McGuire szociálpszichológus alkotta meg, és azt az eljárást takarja, amikor előre tájékoztatják az embereket arról, hogy léteznek képtelen híresztelések és nyílt dezinformációk, majd konkrét példákat mutatnak ezekre, és stratégiákat javasolnak az elkerülésükre. A lap szerint egy 2023-as tanulmány, amely szélesebb körű beavatkozásokat is vizsgált, azt találta, hogy az ilyen típusú felkészítés közepes vagy nagy hatással bírt a téves hiedelmek visszaszorításában.

Léteznek olyan módszerek is, amelyekkel „meg lehet hackelni” az emberek figyelmét.

A Wisconsini Egyetem kutatói egy tavalyi elemzésben például azt mutatták be, hogy a TikTokon közzétett orvosszakértői cáfolóvideók hatékonyabbak, ha gyors tempójú zene szól alattuk. Az amerikai tudósok szerint a zene elnyomja az agy azon képességét, hogy ellenvetéseket állítson elő, így meggyőzőbbé teszi az üzenetet.

Mindez persze szép, csakhogy ezeket a technikákat ugyanúgy használhatják azok, akik terjesztik a valótlanságokat, mint azok, akik le akarják leplezni azokat.

Szóval mindent számításba véve a legerősebb fegyver a konspiráció és a dezinformáció ellen még mindig a kritikai gondolkodás oktatása lehet, amellyel megtanuljuk, hogy hogyan kell értékelni a tényeket a tisztánlátás érdekében. Szerencsére erre is van konkrét bizonyíték: egy 2018-as tanulmány 806 egyetemi hallgató körében kimutatta, hogy a kritikai gondolkodásra neveléssel csökkenteni lehet a földönkívüliekkel, vagy az egészséggel kapcsolatos áltudományok elfogadását. Érdekes módon viszont ugyanebben a kísérletben kiderült, hogy a holokauszttagadás és a holdraszállás meghamisítása kapcsán még az oktatás sem elég hatékony. Érdemes tehát tovább kutatni a témát, mert a dezinformálás olyan méreteket öltött, hogy muszáj globális megoldást találni rá.